آموزش و پژوهش

از جستجوی مقالات انگلیسی و فارسی تا نوشتن مقاله علمی

فرآیند آماده سازی یک مقاله علمی دارای مراحل متعدد و ریزه کاری های بسیار می باشد. در این مطلب در تلاش هستیم تا مروری بر فعالیت ها و اقدامات مورد نیاز برای آماده سازی و تهیه یک مقاله و تحقیق علمی داشته باشیم.

Table of Contents

تعریف مسئله

اولین گام در نگارش مقالات علمی داشتن و تعریف یک مسئله مناسب و درخور توجه بوده که ارزش تحقیق بررسی و وقت گذاشتن را داشته باشد. در هنگام تعریف مسئله دو حالت کلی ممکن است رخ دهد. حالت اول اینکه شما به عنوان محقق یک تعریف مسئله مناسب را از قبل دارید و به دنبال انجام یک تحقیق برای رسیدن به پاسخ سوالات خود هستید. حالت دوم اینکه شما مایل به انجام تحقیق و پژوهش به دلایل شغلی و تحصیلی می باشید. مثلا به عنوان پژوهشگر در یک سازمان مشغول به کار شدید و حالا باید در رابطه با موضوعاتی در یک حوزه کاری معین کار تحقیق و پژوهش را شروع نمایید، یا اینکه وارد دوره کارشناسی ارشد یا دکترا در یک دانشگاه شده و اکنون برای انجام پایان نامه یا رساله خود نیاز به شروع و وارد شدن در فرایند تحقیق و پژوهش هستید. در این هنگام انبوهی از سوالات ذهن دانشجویان و پژوهشگران را درگیر می کند:

- روی چه موضوعی کار کنم؟

- از کجا میتونم یک مسئله مناسب برای کار تحقیق و پایان نامه خودم پیدا کنم؟

- چطوری بین موضوعات مختلفی که به ذهنم می رسد یا بقیه به من پیشنهاد می کنند اولویت بندی کنم؟

- آیا اگر روی این موضوع کار کنم میتوانم نتایج کارم را در قالب یک مقاله علمی در یک ژورنال معتبر چاپ کنم؟

- کدام موضوعات دشواریهای بیشتری در جمع آوری داده ها به همراه دارند؟

و بسیاری از سوالات دیگر که در اینجا فقط به عنوان نمونه به ذکر چند سوال بسنده کردیم.

جستجوی مقالات انگلیسی و منابع علمی

مرور ادبیات یکی از مهمترین گام های فرایند تحقیق می باشد. برای جستجو و یافتن مقالات علمی ابزارهای مختلفی وجود دارد که در ادامه در مورد بررسی قرار خواهند گرفت.

راهنما و آموزش جستجوی مقالات انگلیسی در گوگل اسکالر

معمولاً یکی از اولین گزینه های مورد توصیه برای یافتن مقالات علمی استفاده از گوگل اسکالر می باشد که در چارچوب آن میتوان مقالاتی که قبلاً در زمینه مورد جستجو منتشر شده اند را به سرعت پیدا نمود. در نتیجه استفاده از گوگل اسکالر شما حجم زیادی از اطلاعات را به عنوان نتایج جستجو دریافت خواهید نمود که بایستی بتوانید بر روی آنها عملیات پالایش و انتخاب بهترین و مناسب ترین مقالات برای کار تحقیقی خودتان را انجام دهید. در غیر این صورت زمان زیادی را برای مرور ادبیات صرف نموده بدون اینکه به نتیجه خاصی برسید و بتوانید به صورت اثربخش فرایند تحقیق خود را به انجام برسانید. در ادامه می خواهیم به تعدادی از ترفندها و راهکارها برای استفاده بهتر از ابزار ارزشمند گوگل اسکالر در جستجوی مقالات علمی اشاره نماییم.

یافتن نتایج در گوگل اسکالر- Google Scholar

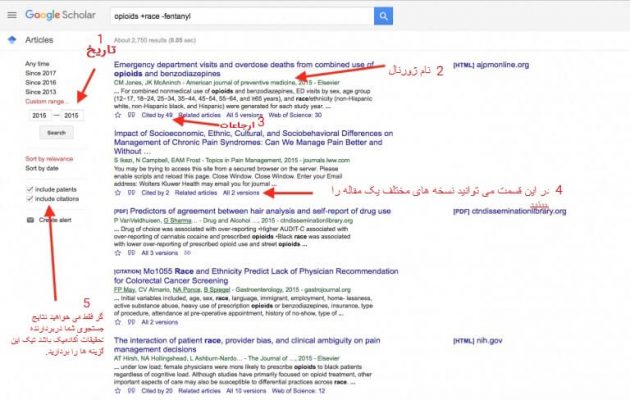

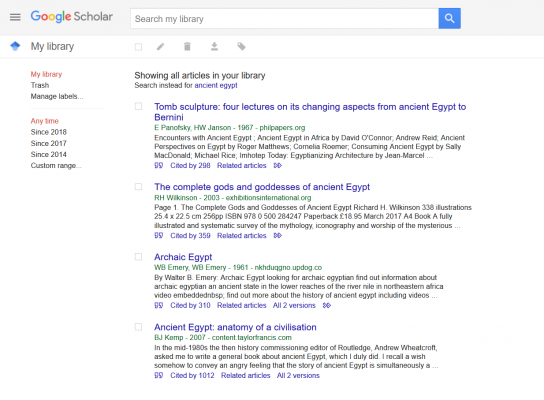

پس از وارد کردن کلمات مورد جستجو نتایج برای شما پدیدار می شود. چیزی که شما می بینید تصویری مانند شکل زیر است که دربردارنده اطلاعات زیر است که در تصویر نیز با شماره مشخص شده است:

۱: این بخش تاریخ انتشار مقالات مورد جستجو را نشان می دهد. بدین صورت که فقط مقالات منتشر شده در رنج زمانی مشخص شده در این قسمت به شما نمایش داده می شود.

۲: در این قسمت نام ژورنال مربوط به هر مقاله را می توانید ببینید.

۳: بخش ارجاعات در این قسمت قرار دارد و مقالاتی که به این مقاله ارجاع دادند و در رفرنس های خود از این مقاله استفاده نموده اند را با کلیک بر روی این قسمت می توانید مشاهده نمایید.

۴: در این قسمت می توانید نسخه های مختلف یک مقاله را ببینید.

۵: اگر فقط می خواهید نتایج جستجوی شما دربردارنده تحقیقات آکادمیک باشد تیک این گزینه ها را بردارید. در این صورت دیگر منابعی مانند پتنت ها در نتایج جستجوی شما نمایش داده نمیشوند.

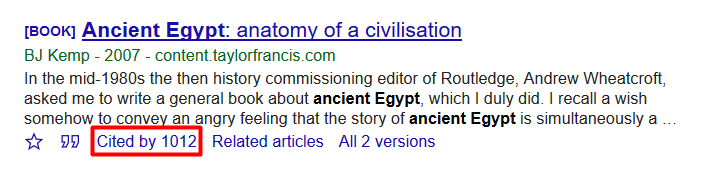

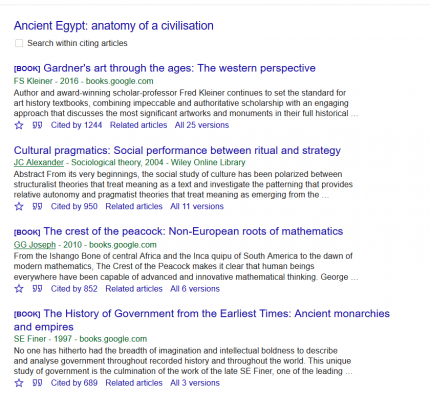

استفاده از ارجاعات (citations)

در گوگل اسکالر ارجاعات مرتبط با هر مقاله نیز در نتایج جستجو نمایش داده می شوند و این موضوع امکان بسیار خوبی برای لینک کردن مقالات به هم و رسیدن به سایر مقالاتی که یک مقاله را مورد ارجاع قرار دادند، می باشد. همچنین این موضوع به محققین و دانشجویان این امکان را می دهد تا دقیقا ببینند که بقیه محققین و پژوهشگران چگونه از یک منبع تحقیقاتی معین برای پیشبرد تحقیق خود استفاده نموده اند. بدین وسیله شما هم می توانید به خوبی تشخیص دهید که آیا این مقاله متناسب و هم راستا با اهداف و نیازهای پژوهشی و موضوع تحقیق شما هم می باشد یا نه؟ همچنین به وسیله این امکان شما می توانید مقالات و منابع علمی که بکر بوده و کمتر توسط محققین دیگر مورد استفاده قرار گرفتهاند را نیز به خوبی شناسایی نمایید و این موضوع هم گام دیگری برای پاسخگویی به نیازهای پژوهش شما می باشد.

جستجو در حالت incognito برای یافتن نتایج بهتر

وقتی که شما در حالت استاندارد و معمولی در در مرورگر خود به عملیات جستجو می پردازید گوگل و گوگل اسکالر از نتایج جستجو های قبلی شما نیز استفاده نموده و لینک هایی که قبلاً شما بر روی آن ها کلیک کرده اید را نیز به صورت هوشمند مورد تجزیه و تحلیل قرار داده و نتایج جستجو های جدید شما را نیز متاثر از رفتار قبلی شما می نماید. این موضوع ممکن است همواره به خوبی عمل ننموده و برای شما مفید فایده نباشد. چرا که جستجو های قبلی شما بر روی جستجو های جدید نیز اثر گذار خواهد بود، در حالی که ممکن است شما تصمیم داشته باشه تا منابع و حوزههای جدیدی را کشف و مورد بررسی قرار دهید و لزومی به برقراری ارتباط با جستجو های قبلی و نتایج کلیک شده بر روی آنها نباشد. در رابطه با جستجوهای عمومی این قابلیت قابلیت ارزشمند و مثمر ثمر میباشد، اما معمولاً برای پیدا کردن متون علمی و تحقیقات آکادمیک و دانشگاهی چندان کارایی ندارد. برای رفع این چالشها می توانید از حالت incognito به جای حالت استاندارد و معمول استفاده نمایید. در این حالت هیچ چیزی از نتایج جستجوی شما ذخیره نمی شود و جستجوهای قبلی شما جستجو های بعدی شما و نتایج آن ها را تحت تاثیر قرار نمی دهد. مثلا اگر شما امروز در رابطه با پیش بینی وضعیت هوا جستجو کرده اید، نتایج جستجو تاثیری بر روی جستجوی چند روز بعد شما در رابطه با تغییرات آب و هوا و چالش های اقلیمی مرتبط نخواهد داشت.

تعریف کلمات کلیدی برای جستجوی اثربخش و دقیق

صرفاً با تایپ چند کلمه نباید انتظار داشته باشید که گوگل اسکالر دقیقاً نتایج مرتبط و مفید را برای شما نمایش دهد. در نتیجه محققین و دانشجویان بارها و بارها جستجو های مختلف را تکرار نموده تا بتوانند نتایج نسبتا قابل قبول و مفید را به دست آورده و منابع علمی مرتبط را پیدا نمایند. به جای آن شما می توانید به موضوع از یک زاویه متفاوت و جدید نگاه کنید. بیایید در ابتدا از خود این سوال را بپرسید که در طول فرآیند تحقیقی خود دوست دارید چه چیزی را یاد بگیرید؟ سپس این موضوعات را به زیر بخش ها و اجزای آن تقسیم نمایید. در این صورت شما به صورت خودکار مجموعه از کلمات کلیدی و اصطلاحات مرتبط قابل جستجو را به دست آورید که میتواند به شما برای یافتن اطلاعات مرتبط برای هر یک از زیربخشهای موضوع تحقیق شما کمک نماید. اگر در ابتدای مسیر تحقیقاتی خود هستید و با موضوع تحقیق خود آشنایی چندانی ندارید، بهتر است که در ابتدا از جستجوهای معمولی در موتور جستجوی گوگل، سایتهای مرجع و دایرهالمعارف هایی مانند ویکی پدیا استفاده نمایید تا یک برآورد و شناخت کلی از موضوع، زمینه های مرتبط و زیر بخش های آن پیدا نمایید. مسلماً نتایج جستجو های عمومی از منظر آکادمیک ارزش و اعتبار بالایی ندارند، اما به وسیله آن ها شما می توانید مجموعه ای از کلمات کلیدی مرتبط و خود را به دست آورید تا به عنوان خوراک اولیه به گوگل اسکالر دهید و بتوانند مجموعه از نتایج غنی و مرتبط از مقالات و منابع علمی را پیدا نمایید.

به صورت سازمان یافته جستجو نمایید.

گوگل اسکالر امکان بسیار خوبی را در اختیار شما قرار داده و شما می توانید در داخل آن کتابخانه هایی برای ذخیره نتایج جستجو های خود ایجاد نمایید.

دامنه این کتابخانه ها بسیار وسیع و متنوع و بسته به نیاز کاربران می تواند متغیر باشد. اولاً شما میتوانید در رابطه با موضوعات تحقیقاتی مشخص خود مثلاً موضوع یک مقاله که در دست تدوین دارید یا موضوع پایان نامه کارشناسی ارشد یا موضوع رساله دکترای خود یک کتابخانه ایجاد نمایید. همچنین شما می توانید در رابطه با حوزه های مورد علاقه خود کتابخانه های جداگانه ایجاد نمایید. حال وقتی که شما در نتایج جستجوی خود به یک مقاله و منبع علمی مناسب و مرتبط برخورد می کنید میتوانید به راحتی آن را در داخل کتابخانه مربوطه ذخیره نمایید یا آن را برای رفرنس دهی های آتی خود بوکمارک نمایید. در هنگام اجرای هر تحقیق علمی و آماده سازی یک مقاله یا پایان نامه یا رساله یکی از موضوعات اصلی، تهیه و تکمیل مورد ادبیات و آماده سازی مقدمه مقاله می باشد. در این راستا بایستی به شناسایی و مطالعه و بررسی کامل منابع مرتبط و همچنین بیان مسئله و سوال یا سوالات اصلی تحقیق پرداخت. استفاده از قابلیت کتابخانه در گوگل اسکالر می تواند برای مقوله های گفته شده به صورت اثربخشی مفید واقع شود.

استفاده از مقالات مرتبط برای یافتن منابع جدید

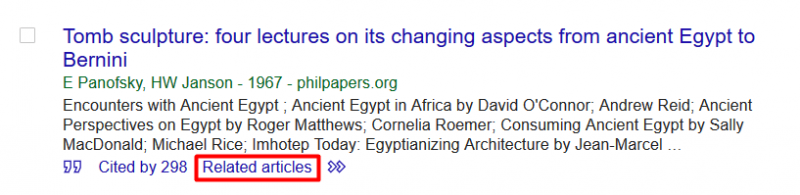

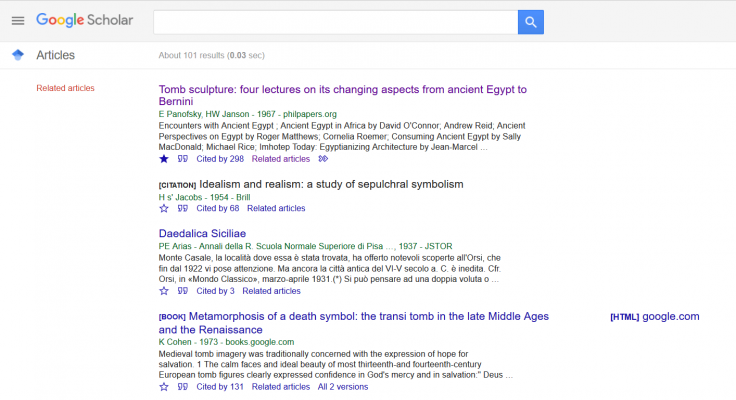

وقتی که شما یکی از منابع پدیدار شده در نتایج سرچ گوگل اسکالر را می بینید، می توانید بر روی گزینه مقالات مرتبط (related articles) کلیک کرده و بتوانید آنها را نیز مورد مطالعه و بررسی خود قرار دهید.

همانطور که انتظار دارید با این کار منابع جدید و متمایزی در رابطه با موضوع مورد جستجوی شما پدیدار می شود. خصوصاً زمانی که تعداد منابع و مقالات یافته شده در رابطه با موضوع مورد تحقیق و موضوع مقاله شما کم باشد، این کار بسیار مفید است. شما می توانید در رابطه با مقالات جدید نیز همین کار را ادامه داده و به شکل سلسله وار جلو روید تا بدین ترتیب به صورت درخت وار و به مانند یک شبکه مویرگی، مرحله به مرحله مجموعه ای از مقالات و تحقیق های مرتبط را مورد شناسایی و بررسی خود قرار دهید.

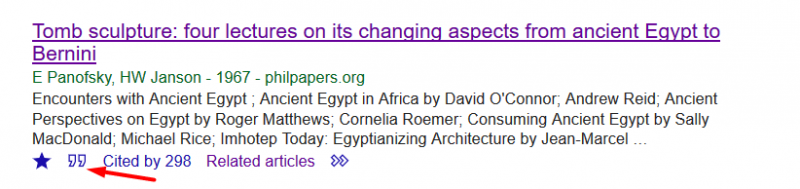

خودکارسازی و سازماندهی به ارجاعات

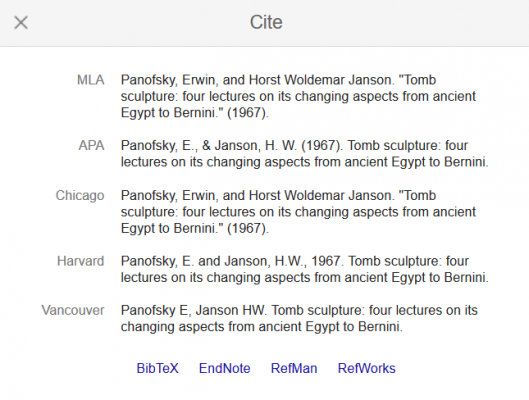

واقعیت آن است که تهیه ارجاعات در مقاله و پایان نامه شما و آماده سازی رفرنس های و مراجع آخر پایان نامه یا مقاله یکی از کارهای خسته کننده و زمان بر می باشد. تمام کسانی که تا کنون حداقل یک بار از صفر تا صد درگیر فرایند نوشتن یک مقاله یا پایان نامه یا رساله بوده اند، این موضوع را با تمام وجود لمس کردند و بر اهمیت و زمان بر بودن آن اذعان دارند. این موضوع وقتی چالشی تر می شود که شما در انتهای یک کار چند ماهه یا حتی چند ساله قرار گرفته باشید و در طول فرایند تحقیق خود هیچگونه برنامه ای برای سازماندهی به منابع و ارجاعات نداشته باشد و الان باید از ابتدا این کار را به صورت کامل انجام دهید. خوشبختانه گوگل اسکالر بخش زیادی از این فرآیند را به صورت خودکار و اتوماتیک انجام می دهد. تنها کاری که شما باید انجام دهید این است که بر روی دکمه ارجاع (cite) که با دابل کوتیشن در پایین هر مقاله و منبع علمی نشان داده شده است، کلیک نمایید.

پس از کلیک پنجره پاپ آپ (pop up) باز می شود که در آن شیوه های مختلف ارجاع دهی یا همان رفرنس دهی به یک مقاله بر اساس استاندارد های مختلف مانند APA یا هاروارد نمایش داده می شود. تنها کاری که شما باید انجام دهید این است که فرمت رفرنس دهی مورد نظر را با کلیک بر روی آن انتخاب نمایید.

سپس ارجاع دهی مناسب به راحتی در اختیار شما قرار گرفته که شما میتوانید آن را کپی کرده و در مقاله یا پایان نامه خود قرار دهید. همچنین شما می توانید این قابلیت را در کنار قابلیت ایجاد و جستجو در کتابخانه ها در گوگل اسکالر مورد توجه قرار دهید که در نتیجه آن شما می توانید به راحتی تمامی منابع و مقالات علمی مرتبط با یک موضوع مشخص را بررسی کرده و ارجاعات مورد نیاز را به راحتی استخراج نمایید. با این کار صرفه جویی زیادی در زمان آماده سازی مقاله و پایان نامه شما به عمل می آید که می توانید این زمان را بر روی ارتقاء محتوا و کیفیت مقاله و پایان نامه خود صرف نمایید. البته ابزارهای دیگری نیز برای ایجاد و مدیریت ارجاعات در مقالات و پایان نامه های علمی وجود دارند، اما قابلیتی که گوگل اسکالر در اختیار پژوهشگران و دانشجویان قرار میدهد در کنار ویژگیهای جستجوی قوی می تواند بسیار تسهیل گر و تسریع کننده باشد.

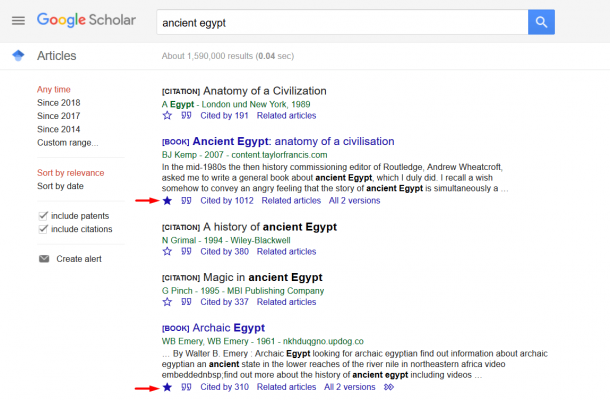

استفاده از جستجوی پیشرفته برای رسیدن به نتایج بهتر

قابلیت جستجوی پیشرفته در گوگل اسکالر نیز مانند خود موتور جستجوی گوگل وجود دارد. به وسیله این قابلیت میتوانید فیلترها و پارامتر های مختلفی را بر روی نتایج جستجو اعمال نموده تا مرتبط ترین و قابل استفاده ترین نتایج را بر اساس نیاز خود به دست آورید. مثلاً شما می توانید نتایج جستجو را به یک دوره زمانی مشخص محدود نمایید. این موضوع برای محققان بسیار کلیدی و قابل استفاده است، چرا که در ابتدا لازم است که بیشتر نتایج سالهای اخیر مثلاً ۳ سال یا ۵ سال اخیر را مورد بررسی و جستجو قرار دهند. خصوصاً وقتی که تعداد مقالات منتشر شده در رابطه با یک موضوع زیاد باشد استفاده از این قابلیت بسیار کمک کننده و تسهیل گرخواهد بود. همچنین شما می توانید بر اساس نام نویسنده جستجو نمایید. این موضوع خصوصا وقتی که میخواهید روند مقالات یک محقق و استاد برجسته در یک موضوع مشخص را دنبال نمایید، بسیار به کمک شما می آید و می توانید به کمک آن از تحقیقات اخیر وی به خوبی مطلع شده و روند تحقیقات وی بر روی موضوعات مشخص در سالهای مختلف از گذشته تاکنون را به خوبی دنبال نمایید. همچنین می توانید نتایج جستجو را محدود به یک آزمایشگاه یا دانشگاه یا حتی یک اسپانسر مشخص برای فعالیت های تحقیقاتی نمایید. این قابلیت نیز بسیار جالب توجه و کلیدی میباشد، چرا که برخی از دانشگاهها در یک حوزه های مشخص پیشرو بوده و بخش زیادی از نوآوریها و انتشار مقالات علمی در آن موضوع را به خود اختصاص دادهاند و شما به عنوان محقق نیز مایلید که در ابتدا مقالات معتبر مربوط به آن آزمایشگاه تحقیقاتی یا دانشگاه را مورد مطالعه و بررسی قرار دهید، چرا که می دانید خروجی های تحقیقاتی آنها دارای اعتبار بالایی می باشد.

استفاده از قابلیت اخطار و اعلام (alerts) برای اطلاع از آخرین مقالات علمی

این قابلیت برای به روز نگه داشتن خود و اطلاع از آخرین مقالات و منابع منتشره در یک موضوع مشخص بسیار کلیدی و کاربردی خواهد بود. شما به عنوان محقق یا دانشجو وقتی که مرور ادبیات خود را به اتمام رسانده و وارد مراحل بعدی آماده سازی مقاله یا پایان نامه خود خواهید شد، نیز از این قابلیت می توانید به خوبی استفاده نمایید. چرا که معمولا وقتی محققان و دانشجویان وارد گام های بعدی تحقیقات می شوند، دیگر زمان زیادی را نمی توانند صرف جستجو نمایند و بایستی بر روی مسئله مشخص خود تمرکز نمایند، اما مسلماً همچنان مایلند که از انتشار آخرین مقالات که می تواند در مسیر تحقیقاتی به آن ها کمک نماید مطلع شوند. در این صورت می توانند به راحتی با استفاده از قابلیت اعلام و فعال سازی آن به صورت خودکار و بدون نیاز به صرف زمان برای جستجو از انتشار آخرین مقالات مرتبط مطلع شوند.

جستجو در ژورنالهای بسیار معتبر

در صورتی که به دنبال جستجو در ژورنالهای بسیار معتبر باشید، می توانید از قابلیت Metrics در گوگل اسکالر استفاده نمایید. این قابلیت را می توانید از منوی باز شونده در گوشه سمت چپ بالا در گوگل اسکالر فعال نمایید.

در پایان این بخش باید گفت که گوگل اسکالر یک ابزار تحقیقاتی بسیار کاربردی و مفید می باشد که روز به روز نیز بر قابلیت ها و هوشمندی آن جهت ارائه نتایج بهتر و مرتبط تر افزایش می یابد. امیدواریم که نکات گفته شده در بالا بتوانند شما محققین و دانشجویان گرامی را در فرایندهای تحقیقاتی خود برای آماده سازی مقالات و پایان نامه ها کمک نماید.

راهنما و آموزش جستجوی مقالات انگلیسی در Sciencedirect

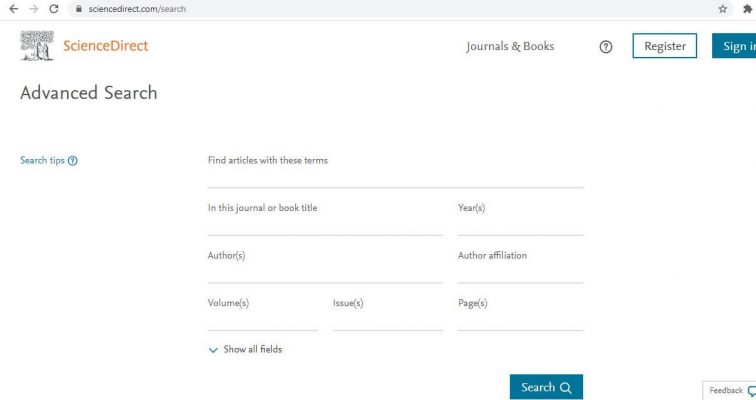

پایگاه علمی sciencedirect یکی از منابع معتبر برای یافتن مقالات علمی می باشد که متعلق به ناشر شناخته شده الزویر (Elsevier) است. پس از ورود به این پایگاه با صفحه مانند شکل زیر مواجه خواهید شد که می توانید به جستجو در قسمت بالای آن و در فیلد های اطلاعاتی مشخص شده بپردازید:

همچنین در صورتیکه بر روی دکمه جستجوی پیشرفته کلیک نمایید به صفحه زیر هدایت خواهید شد که فیلدهای بیشتری برای جستجوی مقالات علمی به زبان انگلیسی را در اختیار شما قرار خواهد داد:

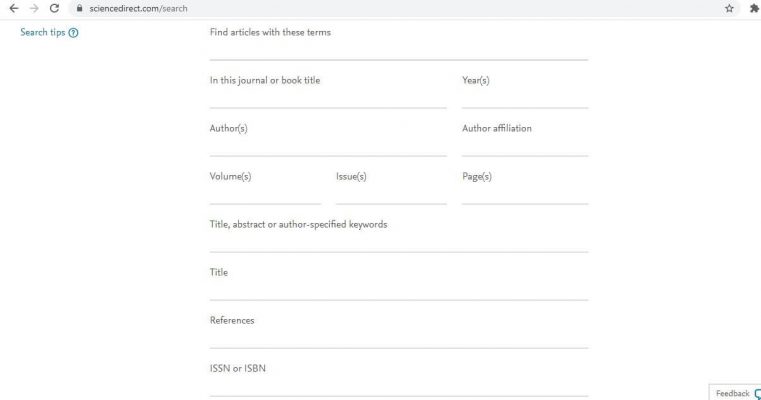

در صورتی که بر روی گزینه show all fields کلیک نمایید تعداد بیشتری از فیلدها برای جستجوی پیشرفته در قسمت پایین صفحه باز شده و در اختیار شما قرار خواهد گرفت، به صورت شکل زیر:

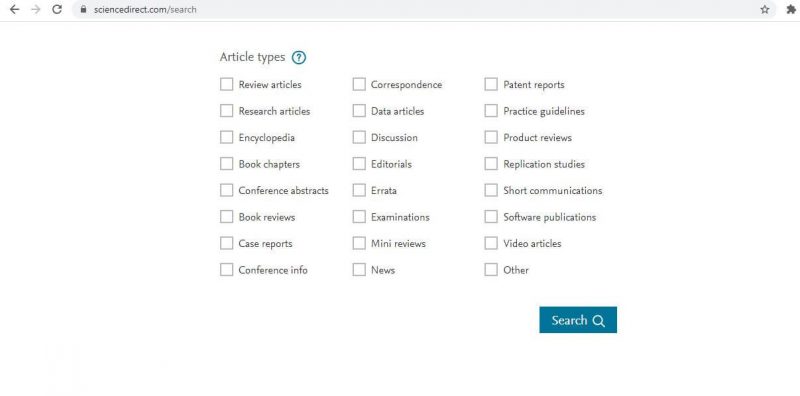

در نهایت در قسمت پایین صفحه حتی می توانید نوع مقاله و منبع مورد جستجوی خود را نیز محدود نمایید، بر اساس شکل زیر:

جستجوی مقالات فارسی

برای جستجو و یافتن مقالات به زبان فارسی نیز مانند زبان انگلیسی پایگاههای متعددی وجود دارد که در این قسمت مهمترین این پایگاه ها مورد بررسی قرار می گیرند.

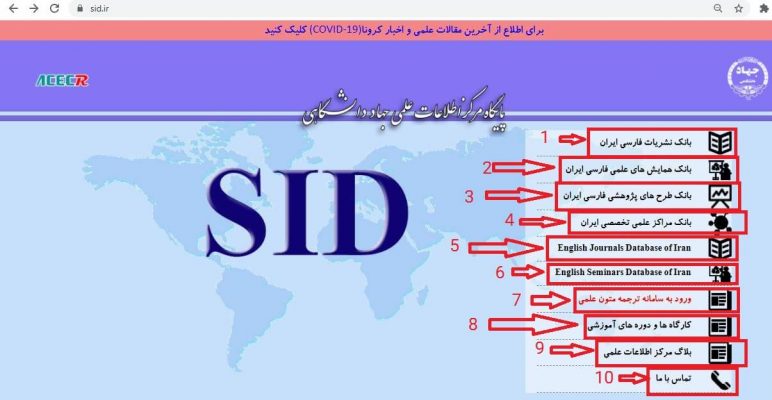

راهنمای جستجوی مقالات فارسی در پایگاه اطلاعات علمی جهاد دانشگاهی SID

پایگاه مرکز اطلاعات علمی جهاد دانشگاهی (SID) یکی از پایگاههای مهم و قوی برای یافتن مقالات فارسی و انگلیسی منتشر شده در ژورنال های داخلی می باشد. در زمان ورود به این پایگاه شما با تصویر زیر روبرو خواهید شد:

در سمت راست تصویر فوق منوی اصلی مربوط به پایگاه مشخص شده است که شامل قسمت های اصلی می باشد. لازم به ذکر است که هر قسمت در شکل فوق با یک شماره مشخص شده که در ادامه می توانید دقیقاً ببینید که هر شماره مربوط به چه قسمتی بوده و در بردارنده چه محتویاتی از مقالات و منابع علمی به زبانهای فارسی و انگلیسی می باشد:

- بانک مربوط به مقالات منتشر شده در نشریات و ژورنال های داخلی به زبان فارسی

- بانک مربوط به مقالات ارائه شده در همایش ها و کنفرانس های داخلی به زبان فارسی

- بانک مربوط به طرح های پژوهشی انجام شده به زبان فارسی

- بانک اطلاعاتی مربوط به مراکز علمی و پژوهشی داخل کشور ایران

- بانک اطلاعاتی ژورنال های انگلیسی زبان داخلی که در این قسمت شما می توانید به مقالات انگلیسی منتشر شده در آنها دست پیدا کنید.

- بانک علمی مربوط به مقالات ارائه شده در کنفرانس ها و همایش های داخلی به زبان انگلیسی

- سامانه ترجمه متون علمی

- کارگاه ها و دوره های آموزشی

- وبلاگ مرکز اطلاعات علمی

- قسمت تماس با ما

مهمترین قسمت های این پایگاه که شما برای یافتن مقالات با آنها کار خواهید داشت بخشهای اول، دوم، پنجم و ششم می باشد.

با کلیک بر روی قسمت اول شما وارد بخش مربوط به جستجو در مقالات فارسی خواهید شد که در این قسمت می توانید به جستجو در صدها هزار مقاله فارسی منتشر شده در ژورنال های داخلی بپردازید. در تصویر زیر نمای این بخش نشان داده شده است:

با کلیک بر روی قسمت دوم شما به بخش مربوط به مقالات فارسی ارائه شده در کنفرانس های داخل کشور هدایت خواهید شد که در تصویر زیر نشان داده شده است:

می بینید که این پایگاه به راحتی امکان جستجو در مقالات همایش ها را نیز در اختیار شما قرار می دهد. مشخص می شود که تصور برخی از محققین و دانشجویان که صرفاً این پایگاه به ایندکس و طبقه بندی مقالات منتشره در ژورنال ها پرداخته، اشتباه بوده و واضح است که مقالات منتشر شده در کنفرانس ها نیز در دامنه فعالیت این پایگاه قرار دارند.

با کلیک بر روی قسمت پنجم شما وارد بخش مربوط به مقالات انگلیسی زبان شده و می توانید در این بخش به جستجو در مقالات انگلیسی منتشر شده در ژورنال های داخلی بپردازید. نمای مربوط به این بخش در تصویر زیر آمده است:

در نهایت قسمت ششم پایگاه را مورد نظر قرار دهید که با کلیک بر روی آن وارد بانک اطلاعاتی مقالات منتشر شده در کنفرانس های داخلی به زبان انگلیسی خواهید شد که با چنین تصویری مواجه می شوید:

راهنمای جستجوی مقالات فارسی در پایگاه سیویلیکا CIVILIKA

سیویلیکا یکی از پایگاه های تخصصی پرکاربرد برای جستجوی مقالات فارسی در کنفرانسها و ژورنالهای علمی داخلی می باشد. این پایگاه خصوصا در رابطه با کنفرانس های برگزار شده در داخل کشور بسیار غنی بوده و می توانید با جستجو در آن به طیف وسیعی از مقالات ارائه شده در کنفرانس ها و سمینارها به راحتی دسترسی داشته باشید.

راهنمای جستجوی مقالات فارسی در پایگاه گنج ایرانداک

پایگاه گنج متعلق به پژوهشگاه علوم و فناوری اطلاعات ایران (ایرانداک) یکی از پایگاههای قوی در رابطه با ایندکس و طبقه بندی پایان نامه های کارشناسی ارشد، رساله های دکترا و همچنین پیشنهادهای مربوط به پایان نامه های کارشناسی ارشد می باشد. با ثبت نام در این پایگاه و از طریق کد ملی خود می توانید در هر هفته به متن کامل ۵ مستند اعم از پایان نامه کارشناسی ارشد یا رساله دکترا دسترسی داشته باشید. توصیه میکنیم جستجو و کار با این پایگاه را حتما تجربه نمایید و مسلماً از منابع غنی و محتوای ارزشمند آن می توانید به خوبی در مسیر تحقیق خود و خصوصاً در بخش جستجوی منابع و مقالات علمی و آمادهسازی مرور ادبیات به خوبی بهره ببرید. مزیت دیگر دسترسی به پایان نامه ها و رساله ها و جستجو در آنها آشنایی شما با ساختار و نحوه تدوین یک پایان نامه کارشناسی ارشد، یک پیشنهاد (پروپوزال) پایان نامه و یا یک رساله دکترا می باشد. موضوعی که بسیاری از دانشجویان و محققین در رابطه با آن ابهامات و سوالات زیادی دارند و همواره از خود سوالات زیر را می پرسند:

- ساختار و ترتیب مطالب در پایان نامه بایستی به چه صورت باشد؟

- هر فصل از پایان نامه و رساله شامل چه بخش های کلیدی و اساسی است؟

- مطلبی که الان در حال نگارش آن هستم متناسب با کدام فصل پایان نامه و رساله بوده و در کجا باید آن را ذکر نمایم؟

- شیوه رفرنس دهی صحیح و بیان مطالب برداشت شده از ادبیات به چه ترتیب است؟

با جستجو در پایان نامه ها و مطالعه آنها شما به راحتی می توانید پاسخ سوالات فوق را به صورت عملی و عینی دریافت نمایید.

راهنمای جستجوی مقالات (راهکارها و ترفندهای کاربردی)

جستجوی مقالات علمی صرفاً وارد کردن یک کلمه و کلیک کردن نیست بلکه باید برای موفقیت در آن و صرفه جویی در زمان خود به صورت سیستماتیک و نظام یافته عمل نمایید. در این قسمت با تعدادی از راهکارهایی که می تواند به شما در حین جستجو کمک نماید، اشاره می شود.

منابع کلمات کلیدی را بشناسید.

معمولا اولین سوال دانشجویان و پژوهشگران قبل از شروع جستجو، در مورد کلمات کلیدی می باشد. اینها جملاتی است که بسیاری از پژوهشگران و دانشجویان می گویند:

- نمی دانم با چه کلمه ای باید جستجو کنم.

- با چند تا کلمه جستجو کردم اما مقاله به دردبخوری پیدا نشد.

- جستجو کردم اما این قدر مقاله زیاد بود سردرگم شدم.

- و سوالاتی از این قبیل

برای رهایی از این ابهامات و سردرگمی ها پیشنهاد می شود ابتدا منابع مناسب برای شناسایی کلمات کلیدی برای جستجو را بشناسید و از آنها به صورت مناسب و دینامیک و انعطاف پذیر برای یافتن کلمات کلیدی مناسب بهره بگیرید. برخی از این منابع عبارتند از:

- جستجوهای عمومی (این موضوع بسیار مهم می باشد و می تواند به شما دید خوبی برای انتخاب کلمات کلیدی مناسب بدهد)

- عکس نوشته یا همان اینفوگرافی ها: عکس نوشته ها منبع بسیار خوبی می باشند و در همان ابتدای کار در زمان کم به شما دید خوبی در رابطه با حوزه های مرتبط با موضوع اصلی تحقیق شما می دهند. مزیت کلیدی عکس نوشته ها در این است که در یک نما و قاب تصویر اطلاعات اصلی را به سرعت دریافت می کنید. فقط کافی است دقیق و هوشمندانه ببینید و حتما حتما دست به قلم یا دست به کیبرد باشید و سریعا کلمات به دست آمده را به صورت دستی یا الکترونیکی ثبت نمایید.

- مشورت با افراد خبره: افرادی که قبلا در زمینه مورد تحقیق تجربه و دانش و سابقه بیشتر از شما دارند نیز می توانند طرف مشورت شما برای پیشنهاد کلمات کلیدی قرار گیرند.

تشکیل سبد کلمات کلیدی

در ابتدا بایستی سبدی از کلمات کلیدی تشکیل دهید که جستجوی خود را با آن سبد آغاز نمایید. مسلما این سبد در طی زمان تغییر کرده و کلمات آن می توانند کم و زیاد شوند. پس ایده آل گرایی در رابطه با کلمات کلیدی نداشته باشید و زیادی حساسیت به خرج ندید که حتما باید از همان ابتدا تمام کلمات کلیدی را به صورت دقیق و کامل شناسایی کرده باشید. این کار معمولا مدت زیادی نیاز به صرف زمان و کسب تجربه و دانش در حیطه مورد تحقیق دارد تا محقق به صورت نسبی به موضوع تحقیق و دامنه آن اشراف پیدا کرده و بتواند کلمات کلیدی را به صورت طبقه بندی شده تشخیص دهد. اما خبر خوب اینکه تجربه نشان داده که فرآیند جستجوی مقالات علمی مانند تکمیل یک پازل چند تیکه بوده و تفاوت چندانی نمی کند که از کدام قسمت و گوشه پازل کار رو شروع نمایید. اگر به اندازه کافی ممارست داشته باشید بالاخره موفق به تکمیل پازل خواهید شد. از این گذشته با شروع جستجو و بررسی مقالات، اگر کلمه جدید و مهمی وجود داشته باشد که در سبد اولیه شما نبوده باشد دیر یا زود بر اثر تکرار این کلمه در مقالات مورد بررسی، شما این کلمه و اهمیت آن را شناسایی خواهید نمود.

به جستجوی عبارت دقیق گیر ندهید!

- مدیریت استراتژیک در هتل داری

- استفاده از منتورینگ برای بهبود ارتباط با مشتری

- بهبود کیفیت به منظور ارتقای فروش

پس به تایپ و جستجوی عبارت دقیق حساس نباشید و همین که عبارت جستجوی شما دربردارنده یک یا چند کلمه کلیدی باشد برای شروع خوب است.

دوباره کاری ممنوع!

سوال ۱:

الف) بر اساس موارد فرا گرفته شده، برای مبحث داده کاوی حداقل ۲۰ کلمه کلیدی را شناسایی نمایید. توضیح دهید که به چه صورت و بر اساس چه موارد و فرایندی این کلمات کلیدی را شناسایی کرده اید؟

ب) کلمات کلیدی را اولویت بندی نمایید و روش اولویت بندی را شرح دهید.

سوال ۲:

شعار گوگل اسکالر این است: Stand on the shoulders of giants که در صفحه اول این سرویس مشاهده میشود. برداشت شما از این شعار چیست؟ و چه چیزی را در رابطه با مرور ادبیات و جستجوی مقالات علمی به ذهن متبادر میکند؟

سوال ۳:

بر اساس موارد فرا گرفته شده، جستجو برای یکی از کاربردهای مورد علاقه خود برای داده کاوی را انجام داده و بررسی عناوین، چکیده و کلمات کلیدی را تا رسیدن به اشباع تقریبی و شهودی ادامه دهید.

الف) چند مقاله را و به چه صورت بررسی نمودید؟

ب) ترکیب کلمات حاصله به صورت دسته بندی شده با ذکر میزان تکرار و اولویت را به گونه ای ارائه دهید که بتوان شما و فهم کلی نسبت به موضوع و ابعاد و جنبه های مختلف و زیرمجموعه های آن بدست آورد.

ج) بر اساس بررسی چکیده مقالات بررسی شده (تعداد را نیز ذکر نمایید) چه زمینه ها و ابزارهایی را برای موضوع مورد جستجو شناسایی نمودید؟ با ذکر میزان تکرار و اولویت بندی پیشنهادی

سوال ۴:

الف) جمع بندی مقالات پیدا شده بر اساس بعد ابزار و روشهای مورد استفاده بیان نمایید.

ب) جمع بندی مقالات پیدا شده بر اساس بعد زمینه و حوزه کاربرد بیان نمایید.

سوال ۵:

استخراج موارد گفته شده از مقدمه و مرور ادبیات برای ۲ مقاله

پاسخ سوالات را در قسمت کامنتها می توانید بیان نمایید.

یادآوری مهم: چون در ادامه سوالات دیگر نیز به این مطلب اضافه خواهد شد و در نتیجه در کامنت حتماً شماره سوال را ذکر نمایید تا پاسخ ها قابل ردیابی و بررسی باشند و مشخص باشد که پاسخ شما مربوط به کدام سوال است.

پاسخ سوال اول :

Data mining,Data analysis, pattern discovery,classification,clustering,Information visualization, Association rule discovery,Clustering,large datasets,Visual data exploration,Visualization with data mining,Data cleaning,text mining ,social media mining, Data mining application, Machine learning,Business Intelligence, Decision tree, Data selection,Data transformation,Regrrssion

ابتدا با جستجوی کلی و ساده اطلاعات کلی درباره ی موضوع بدست آوردم، پس از آن مقالاتی که ارجاعات بیشتری داشتند و طبق سایر نکاتی که در نوشته ی حاضر در سایت توضیح داده شده کلید واژه هایی که بیشتر تکرار شده بودند را به ترتیب اولویت مرتب کردم.البته این اولویت بندی خیلی دقیق نیست چرا که در مقاله ای ممکن است حوزه ای مورد توجه قرار بگیرد که تا کنون کمتر به آن پرداخته شده است(تعداد تکرار کمتر) و این موضوع از نظر من میتواند خیلی ارزشمند باشد چرا که پژوهش های نو را نشان می دهد.

پاسخ سوال (۱)

الف)

۱- big data

۲- BI

۳-cloud computing

۴- data analytics

۵-data exploration

۶-data management

۷- data visualization

۸-descriptive analytics

۹-predictive analytics

۱۰-prescriptive analytics

۱۱-batch processing

۱۲-dark data

۱۳- data lake

۱۴-data mining

۱۵- IOT

۱۶-data acquisition

۱۷- data collection

۱۸-data driven-decision

۱۹-supply chain

۲۰-marketing decision

با استفاده از سرچ در گوگل با عنوان کلمات کلیدی در رابطه با علم داده و داده کاوی و همچنین مشاهده برخی از مقالات درحوزه علم داده و حوزه بازاریابی

ب) کلمات کلیدی بر اساس شماره الویت بندی شده اند و تلاش شده از کلماتی که مشخصا به علم داده مرتبط هستند و یا از کلمه data استفاده شده الویت بیشتری داده شود.

برای پیدا کردن کلمات کلیدی پیرامون موضوع اصلی ابتدا در google scholar کلمه اصلی

مانند Human resource management را جستجو میکنیم و پس از آن از فهرست مقالات، آنها را انتخاب کرده و در بخش انتهایی کلمات کلیدی را پیدا میکنیم. با توجه به تکرار کلمات در مقالات مختلف میتوانیم کلمات اصلی را اولویت بندی کنیم.

کلمات کلیدی : human resource management, human resource management issue,

human resource practice, PERSONNEL management, INDUSTRIAL productivity,

RESOURCE management, COMPETITIVE advantage, ORGANIZATIONAL structure,

cultural difference ,INFORMATION resources management, HUMAN capital — Management,

Performance, Outcomes, EMPLOYEE selection, ORGANIZATIONAL effectiveness,

EMPLOYMENT practices, ORGANIZATIONAL effectiveness, ORGANIZATIONAL behavior,

LABOR productivity, HUMAN capital

پاسخ سوال ۱:

ابتدا با سرچ عمومی اطلاعاتی راجع به مبحث داده کاوی دریافت کرده و سپس در رابطه با الگوریتم های دیتا ماینینگ به عنوان موضوع اصلی با استفاده از گوگل اسکالر و sciencedirect.com به جستجوی مطالب از قسمت citition و related articles و recommended articles و همچنین keyword های مقالات و مطالب پیشنهادی سرچ خود گوگل بدست میاریم.

برای اولویت بندی میتونیم به میزان مطابقت تایتل مقاله و تعداد citition و تاریخ مقاله مربوطه توجه کنیم.

keywords:data mining algorithms ,top 10 data mining algorithms,data mining algorithms classification, application of data mining algorithms, Data mining: concepts and techniques

Data mining:machine learning, The EM algorithm and extensions , big data algorithms,programs for machine learning ,Random forests in data mining ,Apriori Algorithm in data mining ,genetic algorithm in big data ,types of data mining algorithms, privacy preserving data mining algorithms ,privacy preserving data mining algorithmsssas data mining algorithms big data models and algorithms, analyze data mining algorithms,Big Data Smart Cities, Fast algorithms for data

mining,Risk estimation for classification in data mining ,

پاسخ سوال یک: در ابتدا با سرچ کلمه ی data science در گوگل و نگاهی اجمالی به سایت ها و انفوگرافی ها و نیز بررسی کلمات تعدادی از مقالات سایت گوگل اسکالر با سرچ data science domain knowledge این کلمات کلیدی در زمینه ی دیتا و بخش های آن به دست آمده و با توجه به میزان تکرار و اهمیت تقریبی این کلمات اولویت بندی شدند.

۱.statistics

۲.machine learning

۳.big data

۴.knowledge engineering

۵.data driven decision making

۶.data engineering

۷.analysis

۸.descriptive analytics

۹.prescriptive analytics

۱۰.predective analytics

۱۱.scientific thinking

۱۲.interactive analysis

۱۳.innovation technologies

۱۴.information technology

۱۵.deep learning

۱۶.programming

۱۷.artificial intelligence

۱۸.cloud computing

۱۹.classification

۲۰.data integration

پاسخ سوال ۲ :

این جمله بخشی از سخنان نیوتن میباشد که پس از فرمول بندی قوانین جاذبه و رسیدن به شهرت و…گفت: اگر من چیزی بیش از بقیه می دانم به آن دلیل بوده که بر شانه ی غول ها ایستاده ام ،این جمله اهمیت مطالعه ی دقیق کارهای پیشینیان در رابطه با موضوع مورد تحقیق خودمان را نشان می دهد ،به عبارت دیگر وقتی میخواهیم یک نوآوری انجام بدهیم باید یک زمان خیلی زیادی را به کارهایی که پژوهشگران دیگر انجام داده اند (مرور ادبیات) اختصاص بدهیم ، ما قرار نیست دوباره چرخ را اختراع کنیم! و باید در زمینه ی تحقیقات به روز باشیم

پاسخ سوال ۲)

به نظرم منظور از این شعار این است مه پژوهشگر با استفاده از گوگل اسکولار به حجم عظیمی از مقالات و تحقیقات کتنوع دسترسی داره که با استفاده از اون میتونه در بدست آوردن دانش آینده و ایجاد مقالات جدید و تولید علم کنترل داشته باشه.

اون غول احتمالا تشبیه شده به حجم عظیم اطلاعات و مقالات و قدرت علم

پاسخ سوال دو:برداشت من این است که می توان از مقالات افراد که حاصل جستجو ها و تحقیقات آنان است به خوبی استفاده کرد و مجددا کار تکراری انجام نداد. در واقع به این معنا که چرخ را دوباره اختراع نکنیم.

پاسخ سوال ۱) الف: Clustering, Classification, Association rules,Text mining, Machine learning, Big data, Network analytics, Visualization, Artificial intelligence, Decision tree, Evaluation, Prediction, Recommendation systems, Business intelligence, Decision support systems, Data warehousing, Social network data mining, Apriori algorithm, Neural networks, Genetic programming, Logistic regression, K-means clustering, Naive bayes, Gragh-based data mining

این موارد را براساس سرچ های کلی از سایت های مختلف و مقالات مختلف و براساس تکرار آنها شناسایی کردم.

ب)سعی شده کلمات ارائه شده بر اساس اولویت نوشته شوند و این اولویتبندی براساس کلیات موضوع و مباحث کلیتر و تکرار آنها انجام شده است.

پاسخ سوال ۲: در عبارت ایستادن بر شانه های غول ها، منظور از غول ها بزرگان و پیشوان علم هستند و این عبارت به این معنی است که برای بدست آوردن دید وسیع و افقی و چشم اندازی بیشتر و دریافت پیدا کردن زوایای مختلف یک موضوع باید بر شانه های آنه ایستاد و به عبارتی دیگر از تجربیات و علم آنها بهره برد.

پاسخ سوال ۲

به نظرم به این معنیه که شما با تکیه و استفاده از تجارب افراد برتر در حوزه های مختلف میتونی منبع ارزشمندی رو در اختیار داشته باشی و مجبور نیستی هر چیزی رو تجربه کنی و هزینه و تایم براش صرف کنی.

در رابطه با مقاله هم شما میتونی از مقالات معتبری که الان موجود هست و افراد صاحب نظری روش کار کردن استفاده کنی و همونارو ادامه و گسترش بدی و به بهبودهایی دست پیدا کنی تا اینکه صرفا بخوای همه چیز رو از صفر شروع کنی.اینطوری هم تقریبا در جهت خوبی حرکت خواهی کرد و هم بطور محسوسی در وقت و هزینه و انرژیت صرفه جویی میشه.

پاسخ سوال ۲) بنظر من این شعار بیان کننده این است که با استفاده از مطالعات، تحقیقات و مقالات قبلی و معتبر میتوان تحقیقات جدیدی را انجام داد و برای تکامل و پیشرفت در حوزهی تحقیقاتی استفاده کرد.

جواب سوال ۲:

تمامی اکتشافات و اختراعات بشر در طول عمر این کره خاکی بر اساس تجربیات گذشتگان صورت گرفته است. وقتی این جمله معروف نیوتن را می خوانیم باید به ارزش تحقیقات گذشته واقف شویم و از آنها در راستای بهبود عملکرد خود استفاده نماییم. استفاده از موتور جستجوی گوگل در زمینه تحقیقات کمک بسیار زیادی به پژوهشگران دنیا نموده است. حتی در زمینه موتور جستجوی عمومی گوکل نیز تصور کنید یک روز این موتور از دسترس خارج گردد، مطمئنا بسیاری از کارهای معمولی افراد به تعویق خواهد افتاد. بر اساس این حقیقت می توانیم به کار ارزشمند گوگل اسکالر بیشتر پی برد.

پاسخ سوال ۳:

الف) من درباره موضوع داده کاوی در واقعیت مجازی و داده کاوی در تکنولوژی غوطه وری ۱۴ مقاله را از نظر موضوع ، Abstract و key words مورد بررسی قرار دادم. بدین صورت که ابتدا موضوع مقاله را مورد بررسی قرار دادم و سپس نگاهی کلی به شکل skim the text به بخش abstract کردم و بعد از آن کلمات کلیدی را نوشتم.

ب) – data mining (بار۱۲)

virtual reality (بار۱۳) data visualization (بار۹)

visual data mining (بار۷) visualization (بار۷)

immersive visual data mining (بار۶)

data exploration (بار۶) big data (بار۵)

data analysis (بار۳) monitoring (بار۳)

information visualization (بار۳) ۳d representation (بار۲)

visual representation (بار۲) VR (بار۲)

data structure (بار۲) data matrix (بار۲)

cloud computing (بار۲) statistical analysis (بار۲)

immersive (بار۱) expression data (بار۱)

time series data mining (بار۱) human interaction (بار۱)

virtual world (بار۱) human observe (بار۱)

information analysis (بار۱) real-time system (بار۱)

visual object (بار۱)

ج) برای این موضوع چکیده ۱۴ مقاله را به صورت کلی مطالعه کردم.

۳D visual data mining framework – CAVE-SOM

۳D Visual Data Mining

The PlatoCAVE

the MiniCAVE

CAVE-SOM system

the C2

immersive visual data mining (کتاب)

Genome3DExplorer

۲D representations

۳D representation

CAVE-like2

۳D space

پاسخ سوال ۳

الف-چیزی در حدود ۷۰-۸۰ مقاله بصورت سرچ مستقیم و بررسی کی ورد ها و مطالب مرتبط و پس از ان سرچ بصورت اگزکت و phrase انجام شد

ب- بطور کلی در ۵ دسته تقسیم بندی شده که دسته data minig & digital marketing بیشترین تکرار رو داشته با ۲۷ تکرار و عبارت هایی از قبیل :

Data mining in digital marketing

The relationship between Big Data &marketing decisions

Using Data Sciences in Digital Marketing

Understanding the digital marketing environment with KPIs and web analytics

Marketing Intelligence and Big Data

use of Web analytics for digital marketing performance measurement

investigation into big data impact on digital marketing

Marketing and data science

The evolution of direct, data and digital marketing

Application of data mining for enterprise digital marketing strategy making

و…

همچنین دسته بندی بعدی مربوط به machine learning میشود که به دلیل اهمیت ان در دسته جداگانه ای با ۳ تکرار و عبارت هایی نظیر Machine learning applications in operations management and digital marketing قرار میگیرد.

دسته های بعدی مربوط به digital marketing & AI و cloud base و general که مطالب عمومی دیجیتال مارکتینگ میباشد تقسیم میگردند.مجموعا ۱۳ تکرار

ج-مجموعا ۲۰ مقاله بررسی گردید که اکثرا بابررسی ادبیات سیستماتیک و تجزیه و تحلیل وب پیش رفته اند همچنین استفاده از پایگاه های داده نظیر PsyINFO ، ScienceDirect و Web of Science ,Scopus ، PubMed ومدل سازی ساختار و کاوش روابط علی ، پایتون ،الگوریتم (SVM) ،نرم افزار Nvivo و همچنین Clickstream.های مشتریان ،از اطلاعات محصولات و تجربه یا داده های قبلی ،(DTM) و consumer decision journey و… استفاده شده است.

پاسخ سوال ۴

الف-از ابزار ها و روشهایی نظیر مدلسازی ساختار و بررسی روابط و روشهای تجسم داده.همچنین استفاده از دیتاهای افراد در شبکه های اجتماعی نظیر توییتر و دیتای رفتاری انها در وبسایت ها-بررسی ادبیات موضوع بصورت سیستماتیک و از طرقی نظیر مشارکت های علمی-استفاده از پایگاه های داده نظیر Scopus , PubMed PsyINFO ,ScienceDirect ,Web of Science – تخصیص پنهان دیریکله LDA-انالیز احساسی SA-تجزیه و تحلیل متن داده DTM-انواع مختلف داده کاوی مثل درخت تصمیم ، شبکه عصبی ، رگرسیون لجستیک -تکنیک پردازش زبان طبیعی NLP-خوشه بندی و کلاسترینگ و consumer decision journey و همچنین از بررسی کیس های واقعی کسب و کار ها استفاده شده است.

ب-اکثر موضوعات در رابطه با استراتژی های بازاریابی میباشد نظیر توسعه ،طراحی ، لزوم کاربرد و حل مشکلات مدیریتی در دیجیتال مارکتینگ بوده که حدود ۴۰ درصد مطالب را فراگرفته.مورد بعدی در رابطه با رفتار مشتری و مدیریت ارتباط با آن میباشد که چیزی حدود ۲۵-۳۰ درصد مطالب را شامل میشود.و سایر موارد به بررسی این حوزه و هوش بازاریابی و روند های موجود در شکل گیری ان پرداخته شده است.

پاسخ سوال ۴

الف-از ابزار ها و روشهایی نظیر مدلسازی ساختار و بررسی روابط و روشهای تجسم داده.همچنین استفاده از دیتاهای افراد در شبکه های اجتماعی نظیر توییتر و دیتای رفتاری انها در وبسایت ها-بررسی ادبیات موضوع بصورت سیستماتیک و از طرقی نظیر مشارکت های علمی-استفاده از پایگاه های داده نظیر:

Scopus , PubMed ،PsyINFO ,ScienceDirect ,Web of Science

تخصیص پنهان دیریکله – انالیز احساسی (LDA) – ماتریس اصطلاحات (DTM) – انواع مختلف داده کاوی مثل درخت تصمیم ، شبکه عصبی ، رگرسیون لجستیک -تکنیک پردازش زبان طبیعی (NLP)-خوشه بندی و کلاسترینگ و نقشه سفر تصمیم مشتری (consumer decision journey)و همچنین از بررسی کیس های واقعی کسب و کار ها استفاده شده است.

ب-اکثر موضوعات در رابطه با استراتژی های بازاریابی میباشد نظیر توسعه ،طراحی ، لزوم کاربرد و حل مشکلات مدیریتی در دیجیتال مارکتینگ بوده که حدود ۴۰ درصد مطالب را فراگرفته.مورد بعدی در رابطه با رفتار مشتری و مدیریت ارتباط با آن میباشد که چیزی حدود ۲۵-۳۰ درصد مطالب را شامل میشود.و سایر موارد به بررسی این حوزه و هوش بازاریابی و روند های موجود در شکل گیری ان پرداخته شده است.

پاسخ سوال ۳: الف) در حوزه Data mining و CRM، تعداد حدودا ۲۲ مقاله را با توجه به موضوعات ، تعداد بازدیدها و سال های آنها مورد بررسی قرار داده و عناوین،چکیده، کلمات کلیدی و نتایج آن ها را بررسی کردم.

ب) کلمات شناسایی شده به صورت زیر میباشد:

Association rules (تکرار: ۸ بار)

Clustering (تکرار ۷ بار)

Classification (تکرار ۶ بار)

Marketing (تکرار ۵ بار)

Customer loyalty (تکرار ۴ بار)

Customer behavior modeling (تکرار۳)

Forcasting / Prediction (تکرار ۳ بار)

Apriori algorithm (تکرار ۳ بار)

Neural networks (تکرار ۳بار)

Decision making process (تکرار ۳ بار)

Decision tree (تکرار ۳ بار)

K-means algorithm (تکرار ۲ بار)

RFM model (تکرار ۲ بار)

Logistic regression (تکرار ۲ بار)

Relationship marketing (تکرار۲بار)

Sequence discovery/sequential pattern (تکرار ۲ بار)

Data warehousing (تکرار ۲بار)

Segmentation, text mining, time series data, Visualization, Naive bayes, Business intelligence, knowledge management, product category, e-commerce, e-business, fuzzy formal analysis, Data privacy

ج) با بررسی مقالات، برای زمینه های موجود، با توجه به تعداد تکرار آنها میتوان موارد زیر را نام برد:

دسته بندی مشتریانclassification ، خوشه بندیclustering ، بررسی روابط موجود بین رفتار انها یا سبد خرید آن ها Association rules ،

و ابزاز های استفاده شده در آنها الگوریتم های مختلف از جمله: Apriori algorithm, RFM, K-means algorithm, Decision tree و.. را نام برد.

پاسخ سوال۴)

الف) مقالات بر اساس ابزار و روشها جمع بندی شدند

ابزار ها:

Data-analysis algorithms (الگوریتم های آنالیز داده)

A data-merging layer (یکسان سازی لایه های داده)

Knowledge-discovery layer(لایه های دانش بنیان)

Decision-making layer( تصمیم گیری)

Ontology models”(مدل های هستی شناسی)

Big Data Analyses the mechanisms (مکانیزم های آنالیز داده)

Twitter (توییتر)

neural network (شبکه عصبی)

Evaluation of the EES (ارزیابی EES)

Dashboards (داشبورد های داده)

“ICMP data to identify Synergies and dependencies” (سینرژی و وابستگی های شناسایی ICMP)

IOT (اینترنت اشیا)

Twitter (توییتر)

Big Data Analytics (آنالیز داده های بزرگ)

Surveys (نقشه برداری)

Artificial intelligence (هوش مصنوعی)

Internet of things IOT (اینترنت اشیا)

wireless sensor network WSN (شبکه سنسور بیسیم)

Big Data (داده بزرگ)

Internet of Things (اینترنت اشیا)

Deep Learning and Machine Learning Model (یادگیری ماشین و یادگیری عمیق)

Neuro-fuzzy (عصبی فازی)

روشها:

• “A data-merging layer Knowledge-discovery layer Ontology models

• Shapes the release of data analyses the mechanisms

• Execute an in-depth test case

• Analyzing the themes

• Convolution neural network

• Evaluation of the EES

• Dashboards

• Framework design and Implementation

• Concentrating on challenges and difficulties & Literature review

• Review state-of-the-art digital forensic schemes for audio-visual biometric data

• Computational methodology

• Conduct an in-depth case study of a city-in-transformation and adopt the perspective of technology affordances to uncover the varying opportunities enabled by BDA to facilitate the attainment of smart tourism goals

• “Surveys the utility of block chain in various smart communities such as healthcare, transportation, smart grid, supply chain management, financial systems and data center networks””Socio-economic and environmental giving specifics of each category. Finally, some of the best practices for attaining sustainable smart cities are provided”

• Geography of smart cities in the EU27

• Combines these by providing an overview of the three subjects about their points of intersection.”

• Disruptive technology called Block chain”

• Deep Learning and Machine Learning Model”

• Big Data analytics

• Big data analytics

• I describe how the growth of big data is shifting the emphasis from longer term strategic planning to short-term thinking about how cities function and can be managed”

• Define six scenarios based on new

• cities badging themselves as smart, older cities regenerating themselves as smart, the development of science parks, tech cities, and techno poles focused on high technologies, the development of urban services using contemporary ICT, the use of ICT to develop new urban intelligence functions, and the development of online and mobile forms of participation”

ب) جمع بندی مقالات بر اساس زمینه و حوزه کاربرد

• Citizen-centered big data analysis in smart cities (آنالیز داده های بزرگ در شهر های هوشمند)

• A model is presented demonstrating how the data released by the smart cities creates value for the citizens and society (ایجاد ارزش در شهر های هوشمند برای جامعه)

• How to exploit the BDA (Big Data Analytics) to help the conversion of a city Into a smarter location (نحوه استفاده از داده های بزرگ برای تبدیل شهر به محلی هوشمند تر)

• Role of creative skilled migrants in broadcasting an alternative use of Technology in support of a sustainable smart city (نقش مهارت پیشبینی دراستفاده تکنولوژی وحمایت از پایداری در شهر های هوشمند )

• Value and limitations of big data for long-term urban policy and planning (نقش مهارت پیشبینی در پشتیبانی کردن از پایداری در شهر های هوشمند)

• developing a data fusion-based traffic congestion control system in smart cities using a deep learning model (استفاده از یادگیری عمیق در کنترل ترافیک در شهر های هوشمند)

• Tourism development (توسعه توریسم)

• Decision-making in smart cities (تصمیم گیری در شهر های هوشمند)

• Planning and management (مدیریت و برنامه ریزی)

• Education (آموزش)

• Security (امنیت)

• Smart-Sustainable City (شهر هوشمند پایدار)

• Actualizing big data (واقعی سازی داده های بزرگ)

• Block chain (بلاک چین)

• Technologies and sustainable smart cities (تکنولوژی و شهر هوشمند پایدار)

• Data-Driven Decision Making (تصمیم گیری با استفاده از داده ها)

• Concept of the smart city (مفهوم شهر هوشمند)

• Sustainability (پایداری)

• Block chain (بلاک چین)

• Urban Sustainability (پایداری شهری)

• Urban planning and building smart cities (برنامه ریزی شهری و ساخت شهر های هوشمند)

• Future business model (مدل کسب کار آینده)

• City planning (برنامه ریزی شهری)

• Smart cities of the future (شهر های هوشمند آینده)

جواب سوال ۴:

الف)

بر اساس صحبت های استاد، کلمه کلیدی رو به دو مورد زیر محدود کردم:

– یادگیری عمیق در بازده سهام (deep learning in stock returns)

– پیش بینی سهام توسط یادگیری عمیق (stock prediction deep learning)

جالب بود که اکثر مقالات جدید در سال های اخیر در مورد ابزار یادگیری عمیق (deep learning) بوده و مقالات قدیمی با ابزار شبکه های عصبی (neural network) و برنامه نویس ژنتیک (genetic programming) نوشته شده بود.

سپس بر اساس جلسه گذشته یه جدول برای مرور ادبیات با ستون های زیر تشکل داده و ۱۱ مقاله را که انتخاب کرده بودم در آن دسته بندی کردم.

ستون ها شامل:

– ردیف

– زمینه (موضوع)

– ابزارهای استفاده شده

– میزان تکرار

– استناد (نقل قول)

مقالات شامل اطلاعات زیر است:

۱ E Chong, C Han, FC Park 2017 پیش بینی بازار سهام یادگیری عمیق ۳۱۲

۲ T Fischer, C Krauss 2018 پیش بینی بازار مالی یادگیری عمیق ۵۳۱

۳ K Chen, Y Zhou, F Dai 2015 پیش بینی بازده سهام LSTM-based ۲۳۱

۴ R Singh, S Srivastava 2017 پیش بینی سهام یادگیری عمیق ۹۱

۵ W Long, Z Lu, L Cui 2019 مهندسی ویژگی یادگیری عمیق ۸۲

۶ X Ding, Y Zhang, T Liu, J Duan 2015 پیش بینی سهام یادگیری عمیق ۴۴۱

۷ R Akita, A Yoshihara, T Matsubara 2016 پیش بینی سهام یادگیری عمیق ۱۶۳

۸ MA Kaboudan 2000 پیش بینی قیمت سهام برنامه نویسی ژنتیک ۲۳۲

۹ MA Boyacioglu, D Avci 2010 پیش بینی قیمت سهام شبکه تطبیقی ۳۹۵

۱۰ E Schöneburg 1990 پیش بینی قیمت سهام شبکه عصبی ۲۱۰

۱۱ H White 1988 پیش بینی اقتصادی شبکه عصبی ۸۹۲

ب) بر اساس نتیجه حاصله، استفاده از ابزار یادگیری عمیق (deep leaning) برای تحقیق در مورد بازار بورس روش بهتری است.

بنابراین سرچ در مورد ابزارهای شبکه های عصبی و یادگیری ماشینی و یادگیری عمیق را شروع نموده و اطلاعات خوبی از از الگوریتم ها و نحوه عملکرد آن ها کسب نمودم.

در قدم بعدی می بایست مقالات انتخاب شده را مطالعه کرده تا دید کلی نسبت به موضوع پیدا کنم و در زمینه بازار بورس ایران و مقالاتی که در این زمینه منتشر شده است تحقیق نمایم.

پاسخ سوال ۳: الف) در حوزه Data Mining (داده کاوی) و CRM (مدیریت ارتباط با مشتری)، تعداد حدود ۲۲ مقاله را با توجه به موضوعات، تعداد بازدیدها و سال های آنها مورد بررسی قرار داده و عناوین، چکیده، کلمات کلیدی و نتایج آنها را بررسی کرد.

ب) کلمات شناسایی شده به صورت زیر می باشد:

قواعد انجمنی ( Association Rules ) تکرار ۸بار)

خوشه بندی (Clustering) (تکرار ۷ بار)

دسته بندی (Classification) (تکرار ۶ بار)

بازاریابی (Marketing) (تکرار ۵ بار)

وفاداری مشتریان (Customer Loyalty) (تکرار ۴ بار)

مدلسازی رفتار مشتری (Customer behavior modeling) (تکرار ۳ بار)

پیش بینی (Forecasting/ Prediction) (تکرار ۳ بار)

الگوریتم اپریوری (Apriori algorithm) (تکرار ۳ بار)

شبکه های عصبی (Neural networks) (تکرار ۳ بار)

درخت تصمیم (Decision tree) (تکرار ۳ بار)

روند تصمیم گیری (Decision making process) (تکرار ۳ بار)

الگوریتم K-means (تکرار ۲ بار)

مدل RFM (تکرار ۲ بار)

رگرسیون لجستیک (Logistic regression) (تکرار ۲ بار)

کشف توالی (Sequence discovery) (تکرار ۲ بار)

Data warehousing ( انبار کردن داده ها) (تکرار ۲ بار)

Segmentation(خوشه بندی) ,

text mining, (داده کاوی در متن)

time series data, (سری های زمانی)

Visualization(مصور سازی)

, Business intelligence(هوش تجاری)

, Naive Bayes, knowledge management, product category, e-commerce, e-business, fuzzy formal analysis, Data privacy

ج) با بررسی مقالات، برای زمینه های موجود، با توجه به تعداد تکرار آنها میتوان موارد زیر را نام برد:

دسته بندی مشتریان(با الگوریتم های مختلف مثل RFM)، خوشه بندی(با الگوریتم های مختلف مثل K_means)، بررسی روابط بین رفتار آنها یا سبد های خرید آنها(با قواعد انجمنی)، پیش بینی آینده(با سری های زمانی، یا رگرسیون) و .. .

پاسخ سوال ۴ :

الف) ابزار و روش های مورد استفاده :

۳D Self-Organizing Maps- نقشه های خود سازمان یافته ۳ بعدی

۳D visual data mining- داده کاوی بصری به صورت ۳ بعدی

The PlatoCAVE-

the MiniCAVE-

the C2

۳D Scatter Plot- نمودار ۳ بعدی اسکتر

۲D space-فضای ۲ بعدی

( The CAVE-SOM(Cave Automated Virtual Environment – Self-Organizing Map

حفره اتوماتیک محیط مجازی – نقشه های خود سازمان یافته

ب) بر اساس زمینه و حوزه کاربردی :

immersive visual data mining- غوظه وری در داده کاوی بصری

The 3DVDM Approach-رویکرد داده کاوی بصری به صورت ۳ بعدی

genomic databases- پایگاه داده ژنومیک

Virtual Reality- واقعیت مجازی

Immersive Projection Technology – عوطه وری طرح های تکنولوژی

۳D representation- ارائه ۳ بعدی

genomic data visualization – بصری سازی داده های ژنومی

information visualization- بصری سازی اطلاعات

پاسخ سوال ۵:

بخش ۱ : در یکی از این مقاله ها کار گروه ،تجسم پروژه ۳DVDM بوده است.

این شامل بحث در مورد معماری سیستم ، ابزار اکتشاف داده ها و تجربه استفاده از مهارت های ادراکی طبیعی انسان برای استخراج داده ها در VR است.

بخش ۲ : با تکنولوژی واقعیت مجازی امکان درک بصری در محیط غوطه وری ۳ بعدی فراهم شده است. کاربران میتوانند اشیا را از تمام زوایا ، دور و نزدیک بررسی کنند. این روش امکان بهره برداری از مهارت ادراکی انسان برای یافتن الگو های نامشخص در نمایش ۳ بعدی بصری داده ها فراهم میکند. ردیابی و جهت گیری کاربر این امکان برای به جهت تصویر سازی فراهم میکند. این یعنی کار بر میتواند اشیا در زمان واقعی در اطرافشان حرکت کند و انها را از هر طرف ببیند. بنابراین واقعیت مجازی طیف وسیعی از امکانات جدید را برای بیان و بازرسی اطلاعات فراهم می کند.

بخش ۳ :- هدف پروژه های استخراج داده های تجسمی این است که تحلیلگران بتوانند مجموعه داده های بزرگ و پیچیده ای را کشف کنند.

– توسعه یک معماری سیستم مدولار مناسب برای مطالعات تجربی در یک زمینه تحقیق

– مدیریت خودکار جریان داده بین ماژول ها

– کنترل خودکار جریان فرآیند بین ماژول ها

– انعطاف پذیری ساختاری برای اجرای انواع مختلف ماژول ها.

بخش ۴ : بررسی آخرین متدولوژی های نرم افزاری برای بهره برداری بهینه از فناوری VR ، امکان آزادی هرچه بیشتر درجه

یک زبان تصویری مناسب برای بیان اطلاعات در VR. این امر مستلزم تحقیق در مورد چگونگی تولید مصنوعی احساسات ادراکی در VR است که از توانایی های عالی درک انسان برای بهینه سازی محتوای اطلاعات و ساختار داده ها بهره برداری می کند

بخش ۵ : ۳DVDM نام سیستم نرم افزاری برای کاوش در پایگاه داده های بزرگ در VR است. این سیستم شامل ماژولهای مختلف پردازش داده در یک خط لوله با امکان بازخورد از کاربر به هر ماژول است.

موقعیت یک پارامتر اساسی است که نسبی موقعیت اشیا را تعیین میکند

ابعاد یکی از پارامتر ها برای بصری سازی است

اشکال بسایر تعیین کننده هستند و معمولاً تصور می شود که اشکال متقارن نسبت به اشکال غیر متقارن با کارآیی بیشتری رمزگذاری و پردازش می شوند.

بخش ۶ : ساختار ابتدا شامل : توضیح The Visualization System بعد از ان معماری سیستم و اماده سازی اطلاعات – بخش بعدی با عنوان درک نشانه های بصری و توضیح المان های آن- قسمت بعدی ارائه نتایج در ابزار ها متفاوت- در قسمت بعد استفاده و عملکرد سیستم- در قسمت بعد بیان مباحث و اهداف آینده و در نهایت نتیجه گیری پیرامون موضوع

پاسخ سوال ۵ -۲:

بخش ۱) سالهای گذشته شاهد رشد مداوم مقدار داده ها بودیم که در بانک اطلاعات بیولوژیکی ذخیره می شود.

غالباً مجموعه داده ها چنان عظیم می شوند که بهره برداری از آنها را دشوار می کند. استخراج دانش از این داده های خام فرایند مهمی است برای زیست شناسان ، با استفاده از رویکردهای معمول داده کاوی. با این حال ،

بخش۲) دشوار است که با استفاده از ابزار واقعی داده کاوی بیوانفورماتیک ، پرداختن به این اطلاعات ژنومیک انجام شود ، زیرا داده ها از نظر کمی بسیار عظیم می شوند. به عنوان مثال ظرفیت داده های ریزآرایه DNA توسط هزار نفر در چند سال افزایش یافته است.

بخش۳)راه حل ما به زیست شناسان اجازه می دهد تا داده های بزرگ و ناهمگن ژنومی ، نه تنها بانک های اطلاعاتی توالی حاشیه ای را کشف و مدیریت کنند. راه حل ما بر اساس یک الگوی گرافیکی و برهم کنشی مناسب برای داده های ژنومی است ، جایی که ویژگی های توپولوژیک جهانی داده ها به راحتی قابل مشاهده است ، برعکس مرورگرهای پایگاه داده ژنومیک سنتی ، همیشه بر روی بزرگنمایی و سطح جزئیات متمرکز هستند.

بخش۴) ما باید در چگونگی پرداختن به مشکل ناهمگنی قالب این نوع پایگاه داده ، به منظور بررسی آنها با یک الگوی تجسم مشترک ارائه دهیم.

بخش۵) تجسم پایگاه داده- کاوش غوطه وری- دستگاه های کلاسیک غوطه وری

بخش۶)

پاسخ سوال اول قسمت الف:

ابتدا از طریق مشورت با اساتید سابق و دوستانی با سوابق تحقیقاتی مرتبط ,اقدام به سرچ عمومی در گوگل با این قبیل کلمات نمودم : کلان داده,داده کاوی,کاربرد کلان داده در مدیریت پروژه ,آنالیز داده

,big data, data mining,machin learning, Data analysis techniques

در مرحله بعد در گوگل اسکالر همین کلمات را در ترکیب با project management, project compelixity & uncertainty, construction project, BIM, complex adaptive systems, cloud computing

increase project profits with data analysis,……. به کار بردم و بدلیل علاقه به موضوعات بکر و جدید به مقالاتی که در سالهای اخیر در این زمینه منتشر شده و تعداد کمی ارجاع به این مقالات داده شده بود توجه کرده و قسمت چکیده و مقدمه مقالات و تیترهای اصلی را چک میکردم و در هرچند مرحله به قسمت سرچ عمومی بازمیگشتم و پیرامون کلمات کلیدی که در کلید واژه های مقالات پیدا میکردم مطالعه مینمودم . بیست تا از کلمات کلیدی به شرح زیر میباشد :

Data science

Data analysis

Big data

BDA

Systems architecture

Big Data Architecture

BDAS

BDMS

uncommon cases analysis

Pattern recognition and analysis

Artificial intelligence

Pattern analysis

multi-criteria decision making

machine learning

Complexity and uncertainty of the project

Complex systems analysis

Complex data analysis

MOGP and BDA

Genetic algorithm

Database

cloud computing

Data analysis techniques

Complex adaptive systems analysis

Projrct Profit and data analysis

پاسخ قسمت ب) کلمات به ترتیب اولویت نوشته شده اما شخصا کلمات را به صورت گروهی اولویت بندی میکنم (برای مثال دو گروه کلمات را در نظر میگیرم که کلمات هر گروه هم خانواده هستند سپس هر یک از کلمات گروه اول را با هر یک یا دوتا از کلمات گروه دوم ترکیب و سرچ میکنم و براساس نتیجه ترکیب را تغییر میدهم) و با توجه به نو بودن موضوع امکان تغییر این اولویت ها یا جایگزین و حذف شدن کلمات در ادامه مطالعات وجود دارد.

پاسخ سوال اول قسمت الف) :

ابتدا از طریق مشورت با اساتید سابق و دوستانی با سوابق تحقیقاتی مرتبط ,اقدام به سرچ عمومی در گوگل با این قبیل کلمات نمودم : کلان داده,داده کاوی,کاربرد کلان داده در مدیریت پروژه ,آنالیز داده

,big data, data mining,machin learning, Data analysis techniques

در مرحله بعد در گوگل اسکالر همین کلمات را در ترکیب با project management, project compelixity & uncertainty, construction project, BIM, complex adaptive systems, cloud computing

increase project profits with data analysis,……. به کار بردم و بدلیل علاقه به موضوعات بکر و جدید به مقالاتی که در سالهای اخیر در این زمینه منتشر شده و تعداد کمی ارجاع به این مقالات داده شده بود توجه کرده و قسمت چکیده و مقدمه مقالات و تیترهای اصلی را چک میکردم و در هرچند مرحله به قسمت سرچ عمومی بازمیگشتم و پیرامون کلمات کلیدی که در کلید واژه های مقالات پیدا میکردم مطالعه مینمودم . بیست تا از کلمات کلیدی به شرح زیر میباشد :

Data science

Data analysis

Big data

BDA

Systems architecture

Big Data Architecture

BDAS

BDMS

uncommon cases analysis

Pattern recognition and analysis

Artificial intelligence

Pattern analysis

multi-criteria decision making

machine learning

Complexity and uncertainty of the project

Complex systems analysis

Complex data analysis

MOGP and BDA

Genetic algorithm

Database

cloud computing

Data analysis techniques

Complex adaptive systems analysis

Projrct Profit and data analysis

پاسخ قسمت ب) کلمات به ترتیب اولویت نوشته شده اما شخصا کلمات را به صورت گروهی اولویت بندی میکنم (برای مثال دو گروه کلمات را در نظر میگیرم که کلمات هر گروه هم خانواده هستند سپس هر یک از کلمات گروه اول را با هر یک یا دوتا از کلمات گروه دوم ترکیب و سرچ میکنم و براساس نتیجه ترکیب را تغییر میدهم) و با توجه به نو بودن موضوع امکان تغییر این اولویت ها یا جایگزین و حذف شدن کلمات در ادامه مطالعات وجود دارد.

پاسخ سوال۵)

در رابطه با موضع داده کاوی در بازاریابی

مقاله شماره یک با عنوان

A framework for big data analytics in commercial social networks: A case

study on sentiment analysis and fake review detection for marketing

decision-making

بیان مسئله

داده های بزرگ یکی از مهمترین چالشهای دانشگاهیان و پزشکان است. هر روز ، حجم عظیمی از داده ها از منابع مختلف با سرعت زیادی تولید می شود. توانایی شرکت ها و مدیران در تبدیل این داده ها به اطلاعات ارزشمند می تواند تفاوت بین موفقیت و شکست کسب و کار را ایجاد کند. از این نظر ، تجزیه و تحلیل داده های بزرگ به سرعت در حال تبدیل شدن به روندی متداول است که توسط بسیاری از سازمان ها با هدف کسب اطلاعات ارزشمند اتخاذ شده است. از طرفی هم دانش محدودی در مورد چگونگی تبدیل شرکت ها و سازمان ها از پتانسیل ارائه شده توسط داده های بزرگ به ارزش واقعی اجتماعی و اقتصادی وجود دارد. از این رو ، تقاضای فزاینده ای برای برنامه هایی وجود دارد که می توانند به سرعت تجزیه و تحلیل داده های بزرگ را برای مشاغل فراهم کنند.

ضرورت

از نگاه بازاریابی نیاز به تحلیل و شکل دادن به داده های بزرگ در جهت شناخت بهتر مشتریان و پاسخ به خواسته هاشون یکی از مهمترین ضرورت هایی است که که نیاز است تا برنامه هایی که در حوزه بازاریابی و در نقش تحلیل این داده ها ساخته شده اند گسترش پیدا کنند.

فرضیات

پیدا کردن کاربرد های نظر کاوی و ارزش مصرف کنندگان در تجارت الکترونیک به جهت برند سازی و تشخیص نظردهی های جعلی و غیر واقعی از واقعی با استفاده از تکنیک های کلان داده و تجزیه تحلیل نظرات

اهداف

ایجاد چارچوبی که به مدیران بازاریابی این اجازه را میدهد تا به راحتی محتوای ایجاد شده توسط کاربر را تفسیر کند و به تخمین های کمی تبدیل کند

طراحی یک معماری مدولار که ابزارهای نظر کاوی و تشخیص نظرات جعلی از واقعی را در راستای کمک به مدیران بازاریابی و مشتریان به جهت تصمیم گیری راحت تر تجمیع میکند

موضوعات

این مقاله به شرح زیر است: بخش ۱ مقدمه ای در مورد استفاده از تجزیه و تحلیل احساسات و ارزش بررسی مصرف کنندگان در تجارت الکترونیکی برای برندسازی است. بخش ۲ یک مرور مختصر ادبیات از کارهای مرتبط در مورد تکنیک های کلان داده های کاربردی در بازاریابی ، تجزیه و تحلیل احساسات و تشخیص و بررسی نظرات جعلی است. بخش ۳ چارچوب پیشنهادی را ارائه می دهد. بخش ۴ مجموعه داده ها و چارچوب و آزمایش و نتایج را توضیح می دهد. و در آخر ، بخش ۵ نتیجه گیری و ایده هایی را برای کارهای آینده ارائه می دهد.

خلاصه مرور ادبیات

مقاله مبتنی بر تجزیه و تحلیل نظرات به صورت خودکار و بررسی نظرات جعلی است چالش ها و فرصت های استخراج شده از این اثر که نشانگر سهم شرکت ها در زمینه کسب و کار است.

نظرکاوی

بررسی نظرات جعلی

چالش ها و فرصت ها

مقاله شماره دو با عنوان:

Social media marketing: Who is watching the watchers

مسئله

در حالی که اثبات شده است که توجه به شبکه های اجتماعی برای کسب و کارها برای درک بهتر صحبت های مشتریان و مردم در مورد محصولات یا خدماتشان بسیار ارزشمند است ، اما ممکن است همه مصرف کنندگان با چنین شیوه هایی راحت نباشند. و اگر آنها با استفاده و چگونگی استفاده بازاریابان از داده های رسانه های اجتماعی آنها راحت نباشند ، ممکن است در مصرف کنندگان نگرشهای منفی ایجاد کنند ، که ممکن است به نوبه خود بر قصد خرید مصرف کنندگان تأثیر بگذارد و منجر به از دست دادن اعتماد و رابطه بین مصرف کننده و شرکت شود.

ضرورت

در حالی که دیدگاه بازاریابان برای درک شیوه های حرفه ای مهم است ، دانش کمی در مورد نگرش مردم نسبت به بازاریابی با استفاده از داده های رسانه های اجتماعی آنها وجود دارد که یکی از مهتمرین موضوعات به جهت پرداختن میباشد.

اهداف و فرضیه

بررسی نگرش افراد با استفاده از داده های رسانه های اجتماعی که اجازه دسترسی عمومی در آنها وجود دارد

سوالات

پیشنهاد استراتژی هایی برای بازاریابان که می توانند در پاسخ به این سوال که چگونه ناراحتی مصرف کنندگان را از استفاده از داده های رسانه های اجتماعیشان کاهش دهند استفاده کنند.

مرور بر ادبیات و تعاریف کلیدی

بازاریابی شبکه های اجتماعی و اخلاق در بازاریابی

استفاده از نظریه مدیریت حریم خصوصی ارتباطات پترونیوس برای هدایت تحقیق و سه فرضیه

روش ها و تجزیه و تحلیل داده ها

پاسخ سوال ۵:

پس از بررسی مقدمه ی مقاله ی انتخابی برای استخراج بخش های مختلف مقدمه آن، نتیجه به صورت زیر است:

(لازم به ذکر است که فایل word ی نیز تهیه شده که در صورت امکان ارائه می گردد)

عنوان مقاله:RFM model for customer purchase behavior using K-Means algorithm

مدل RFM برای تحلیل رفتار خرید مشتریان با استفاده از الگوریتم K-Means

بخش های مقدمه به شرح زیر می باشد:

۱- بیان مسئله:

در پرتو تقسیم بندی داده ها، مشتریان به مجموعه ای از افراد با شباهت های مجزا تقسیم می شوند. برخی از ویژگی های مربوط به تقسیم-بندی مشتری جنسیت، سن، سبک زندگی، مکان، خرید و رفتار درآمد است. چنین ویژگی هایی عمدتا براساس رفتار خرید تاریخی طبقه¬بندی می¬شوند که می¬تواند منجر به نتیجه خاصی شود، به عنوان مثال ، افزایش فروش و سود برای شرکت.

۲-اهمیت و ضرورت

در رقابت روزافزون و افزایش پیچیدگی فضای کسب و کار، تقسیم بندی و مطالعه سیستماتیک مشتریان، وفاداری مشتریان را بهبود می¬بخشد و سطح تعاملات شرکت و مشتریان را برای برقراری روابط طولانی مدت با گسترش پایگاه داده مشتریان سودآور، افزایش می-دهد (خلیلی-دامغانی و دیگران ، ۲۰۱۸).

هنگامی که خوشه بندی مشتریان به خوبی انجام شود، در تخصیص موثر منابع بازاریابی کمک می¬کند، شرکت¬ها را قادر می¬سازد گروه خاصی از مشتریان را هدف قرار دهند و همچنین در ایجاد یک رابطه سالم و طولانی مدت با مشتریان کمک می¬کند.

همچنین ، داده¬کاوی در صنعت خرده فروشی به شناسایی و ترسیم موثر رفتار مشتری و الگوهای مربوط به آن در کل طول چرخه عمر (زندگی) معاملات تجاری کمک می¬کند. که این در نهایت منجر به بهبود خدمات به مشتری، فروش و استراتژی¬های توزیع و موارد دیگر می¬شود (هان و همکاران ، ۲۰۱۱)

۳- obcective اهداف و وجه تمایز

در محدوده مطالعه حاضر، از بینش کمی به منظور خوشه بندی و تقسیم بندی استفاده می¬شود.

این تحقیق، عمدتا بر ردیابی و نظارت بر رفتار خرید گذشته مشتریان با هدف یافتن حداکثر میزان فروش ممکن در منطقه¬ای خاص متمرکز است.

برای دستیابی به اهداف فوق، خوشه¬بندی و تقسیم¬بندی مشتری با استفاده از الگوریتم K-Means انجام می¬شود.

۴- فرضیه¬ها

براساس مقادیر RFM برای مناطق مختلف است.

در ابتدا خوشه¬ها با استفاده از تجزیه و تحلیل Silhouette برای Recency. در مقابل Monetaryدر روش K-Means ، برای تعداد مختلف خوشه¬ها رزیابی می¬شوند.

در تحقیق حاضر، ضریب سیلوئت هر دو انسجام و جدایی را با هم ترکیب می¬کند.

۵- تعاریف کلیدی و مفهومی

بر اساس نتایج آماری و شاخص¬ها¬، شرکت¬های صنعت خرده فروشی می¬توانند استراتژی¬های مختلف فروش و بازاریابی مانند کمپین¬های تبلیغاتی، افزایش تخفیف¬های فصلی یا کوپن¬های فروش شناور را برای افزایش فروش و بهبود حفظ مشتری طراحی کنند.

RFM را می¬توان به عنوان یک تکنیک تقسیم¬بندی برای تجزیه و تحلیل مشتریان تعریف کرد که نه تنها اطلاعاتی راجع به الگوی خرید مکرر مشتری، بلکه درمورد خریدهای اخیر و سود حاصله، نیز می¬دهد. (هو و یه ، ۲۰۱۴).

تجزیه و تحلیل سیلوئت یک روش مبتنی بر نمونه اولیه برای ارزیابی یا اعتبار سنجی خوشه¬ها است. اعتبار می¬تواند انسجام باشد یا تفکیک، یا ترکیبی از هر دو باشد.

پاسخ سوال ۲: این جمله به اهمیت تکیه به تجربه پیشینیان برای پیشرف اشاره دارد در هر زمینه ایی همیشه افراد نواور و محقق وجود دارند که با نواوری ها و پژوهش هایشان پله هایی برای پیشرفت محققان بعدی میسازند . در زمینه پژوهش و نواوری , این جمله به معنی بررسی کامل مطالعات انجام شده پیشین در رابطه با موضوع مورد پژوهش و سپس ارائه نوآوری هاست.

پاسخ سوال سوم. الف) در زمینه کاربرد داده کاوی و یادگیری ماشین در پروژه های عمرانی مطالعاتی نمودم که شامل بررسی حدود ۱۵ مقاله فارسی و ۵ مقاله انگلیسی(با توجه به زمان کم برای ارائه به استاد راهنما) را با توجه به کلمات کلیدی و چکیده انتخاب و سپس کامل مطالعه نمودم. همچنین چکیده ۲۰ مقاله انگلیسی بررسی شد.

ب)

این کلمات هم به صورت فارسی و هم انگلیسی سرچ شدند .a دسته اییست که بیشترین ترکیب با کلمات دیگر را دارد و به همین ترتیب b و c کمتر در ترکیبات سرچ استفاده شدند:

c. چالش های مدیریت پروژه

a.پیچیدگی پروژه

a.عدم قطعیت و پروژه های پیچیده

b.الگوریتم های تحلیل داده

a.داده کاوی و عدم قطعیت پروژه

a.یادگیری ماشین و پروژه های ساخت

b. شبکه عصبی مصنوعی

b. شبکه عصبی پیچشی و بازگشتی

a. الگوریتم ژنتیک

a.زمان و هزینه پروژه و هوش مصنوعی

a. الگوریتم های یادگیری ماشین و پروژه های ساخت

ج)

با بررسی چکیده حدود ۴۰ مقاله ,به کابرد هوش مصنوعی و الگوریتمهای مختلف یادگیری ماشین علاقمند شدم و برای براورد زمان و هزینه و بهره وری پروژه های ساخت در شرایط عدم قطعیت و تحت تاثیر ریسکهای مختلف پروژه تا کنون به چند مقاله برخوردم که در انها از الگوریتم های شبکه عصبی و بیزین و ماشین بردار پشتیبان و الگوریتم ژنتیک به صورت ترکیبی استفاده شده بود.

هم اکنون به دنبال یافتن ترکیبی از الگوریتمها و یکپارچه سازی ان با سیستمهای کنترل پروژه (که در حال حاضر در شرایط پیچیده پاسخگوی نیازهای مدیر پروژه نیستند) هستم تا در هر شرایطی با ورود داده های جدید حتی به صورت فیلم و عکس, بهره وری ,ریسکهای احتمالی و همچنین زمان و هزینه به صورت احتمالی مشخص و راه حل های مناسب ارائه گردد.

الف) ۴.برای کشف الگوهای پنهان موجود در کلان داده ها که انواع مختلفی چون ساختار یافته نیمه ساختار یافته و ساختار نیافته دارند, همچنین برای تبدیل این داده ها به اطلاعات و دانش و استفاده از انها جهت تسهیل در تصمیم گیری و پیش بینی , روشهای مختلفی بنا به مورد کاربرد وجود دارد از جمله : شبکه عصبی ,خوشه بندی , دسته بندی , درخت تصمیم و الگوریتمهایی چون KNN و c4.5 که با استفاده از فن اوری هایی چون R و python و rapid miner و apache و cloud computing این تکنیکها پیاده سازی میشوند.

ب) داده های کلان و داده کاوی در علوم مختلفی کاربرد دارند زمینه هایی که در مقالات مورد بررسی به ان برخوردم عبارند از: بهینه سازی تصمیم گیری در حوزه تجارت، پیش بینی روند در بورس ,تهیه سبد محصولات با بیشترین محبوبیت جهت دستیابی به سود بیشینه, کشف الگوی پیشرفت کار پروژه های ساخت تعیین بهره وری انجام پروژه ،مدیریت دارایی و منابع پروژه ها، تسهیل فرایند طراحی در ساخت مطابق با خواسته ذینفعان ،کشف احتمال بروز ریسک ها و گلوگاه ها در فرایند تولید محصول و ساخت و ….

پاسخ سوال ۵:

مقاله :بررسی کاربرد الگوریتمهای یادگیری ماشین در مهندسی و مدیریت پروژههای ساخت

نگین بابایی *۱ ، غلامرضا هروی ۲ ، محمد هادی چرخکان /دوازدهمین کنگره ملی مهندسی عمران۱۳۹۹ خرداد

صنعت ساخت به دلیل عدم قطعیتهای ذاتی و ماهیت پیچیده و رقابتی خود به ابزارهای ویژهای برای تصمیم سازی نیاز دارد. گرچه روشهای مرسوم مورداستفاده در مدلسازی مانند سیستمهای مبتنی بر نظر خبرگان، سیستم پویا و … تاکنون به حل مسایل مدیریتی و مهندسی صنعت ساخت کمک کرده اند، اما یا نیاز به شناخت دقیق از سیستم دارند که در بیشتر مسایل امری دشوار است و یا تعصبات و قضاوتهای انسانی را وارد مدل میکنند که از دقت و جامعیت مدل میکاهد. یادگیری ماشین که زیر شاخهای از علوم کامپیوتر است، با استفاده از دادههای موجود توانایی تشخیص الگو و پیش بینی در مسایل پیچیده که از مدلی مشخص پیروی نمیکنند را دارد ]۱[ . پیشرفتهای تکنولوژی در چند دهه ی گذشته نیز با برطرف کردن محدودیتهای این روش از یک سو و تولید و ذخیره ی حجم بالای داده از سوی دیگر به گسترش استفاده از این حوزهی علمی کمک شایانی کرده است ]۲[ .

یادگیری ماشین در مسایل صنعت ساخت میتواند در حوزه های ایمنی، پیش بینی زمان و هزینه، تحلیل ریسک، پیش بینی نتیجه ی ادعاها وتعارضات و… کاربرد داشته باشد. این مقاله ابتدا به معرفی اجمالی الگوریتمهای متداول و برشمردن مزایا و معایب هریک میپردازد و سپس تعدادی از پژوهشهای انجام شده در حوزهی مهندسی و مدیریت ساخت در سالهای اخیر که با بهره گیری از هوش مصنوعی انجام شده اند را بررسی کرده و در انتها با جمع بندی مطالب گفته شده راهنمایی جهت انتخاب الگوریتم مناسب ارایه میکند.

مقاله:Ibrahim K. F., et al. (2017). “BIM Big Data system architecture for asset management: a conceptual

framework”. In: Proc. Lean & Computing in Construction Congress (LC3), Vol. 1 (CIB W78), Heraklion,

Greece, pp.

در حال حاضر ، تقریباً هر بخش اقتصادی از جمله حسابداری ، گردشگری ، حمل و نقل ، آموزش و ساخت و ساز تحت تأثیر Big Data قرار دارد. این عمدتا به دلیل قابل توجه بودن قابلیت های Big Data در ذخیره سازی ، پردازش و تجزیه و تحلیل حجم زیادی از داده های متنوع بوده است. در عین حال ، مدل سازی اطلاعات ساختمان (BIM) به معیار جدید بین المللی برای کارایی و همکاری بهتر در طراحی ، ساخت و ساز و بهره برداری و نگهداری ساختمان تبدیل شده است. BIM می تواند به عنوان یک مجموعه داده در تمام مراحل برای تمام داده های ساختمان عمل کند ، حتی از سایر فن آوری ها مانند سیستم های اطلاعات جغرافیایی (GIS) ، شناسایی فرکانس رادیویی (RFID) ، اینترنت اشیا و واقعیت افزوده (AR). علاوه بر این ، داده های منابع مختلف مانند مدیریت دارایی ، مدیریت انرژی ، و پایگاه داده های مواد و منابع می توانند در یک محیط BIM ادغام و پیوند داده شوند. در نتیجه ، BIM می تواند با حجم زیادی از داده های ناهمگن مقابله کند که در بیشتر مواقع منجر به یک مانع همکاری می شود. اگرچه رایانش ابری و تجزیه و تحلیل داده های بزرگ می توانند قابلیت همکاری را بهبود بخشند ، اما پذیرش Big Data در BIM برای مدیریت دارایی در مرحله نوپا و فاقد چارچوب ها و دستورالعمل های مشخص باقی مانده است. مزایای بانک اطلاعاتی مدیریت دارایی بر اساس داده های BIM و BIG می تواند شامل بهبود عملکرد مالی ، تصمیمات آگاهانه سرمایه گذاری دارایی ، بهبود خدمات و بازده ، خطرات مدیریت شده و انطباق نشان داده شده (Spilling 2016) باشد.